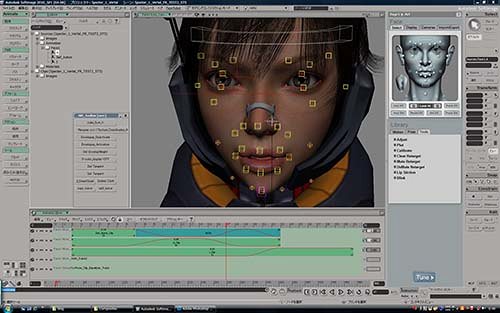

この機能はキャプチャーした映像のマーカーを解析して得た座標データを元にフェイシャルコントロールをしようとするもので、通常使用ではあまり恩恵を得ることはないように思う。

キャプチャーデータ有りきで考えられているのでリップシンク機能が存在しないからだ。

「結構、イタイと思う」

なぜなら、大抵のプロジェクトではフェイシャルは手付けが基本だからだ。

だからほとんどのフェイシャルアプリケーションは、音声解析をベースにリップシンクをおこなうものが主流となっている。

まぁ、フェイシャルコントローラーを作成することができない状況では、あればあったで便利なのかも知れないが・・・

処理の重さやEtc…を考えると、自分でセットアップしコントローラーを自作した方がいいと思う。

せめて動画からマーカーを抽出してFaceRobotにモーションを書き出せるツールでも付属していればよっかったのだが、、、

・・・それでも撮影なとが面倒だから、リップシンク機能はほしいなぁ。

今のところの感触としては、

「新しい機能なので今後に期待」

っといった感じ。

まさか、

自分がリップシンク機能を見落としているだけなのか?

自分がリップシンク機能を見落としているだけなのか?